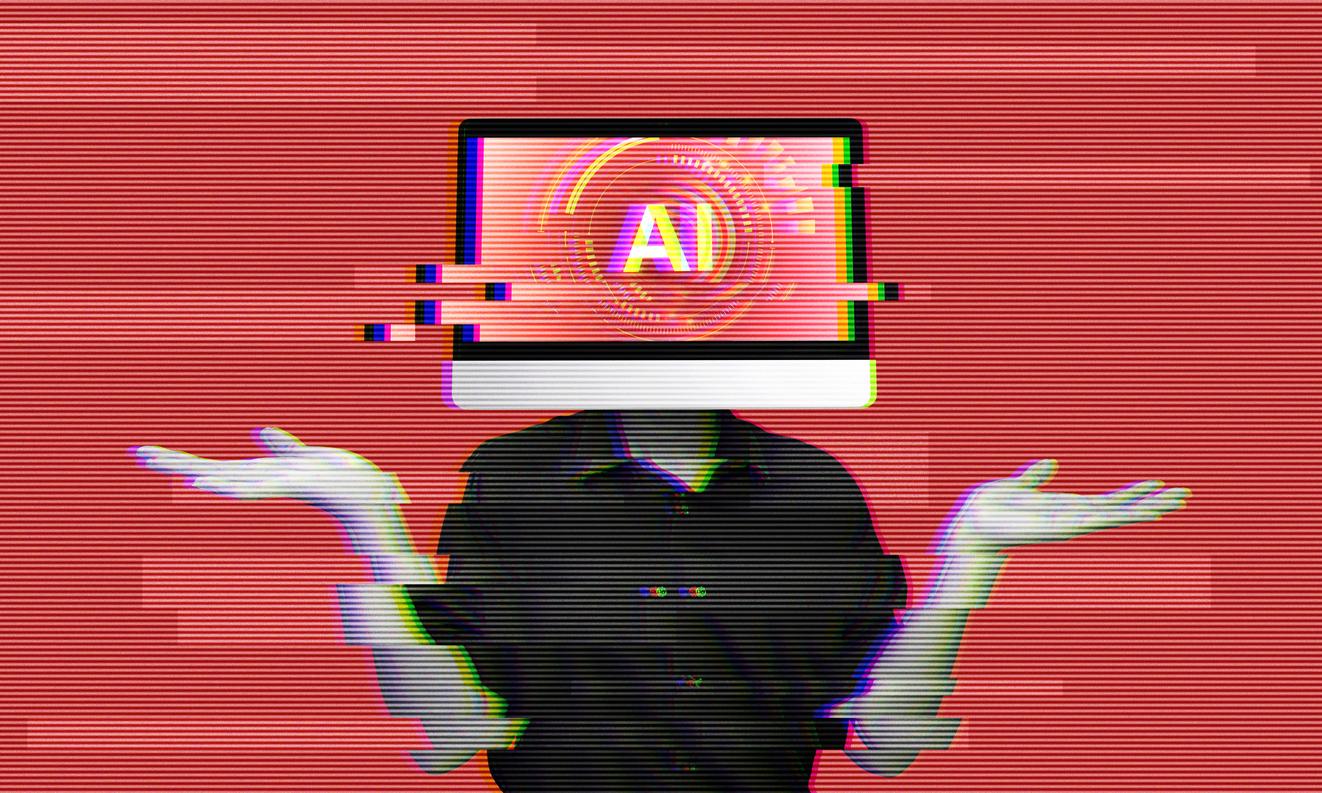

IA

Etats-Unis : il s’empoisonne au brome sur les conseils de ChatGPT

Après avoir suivi un conseil trouvé via ChatGPT, un sexagénaire américain a remplacé le sel par du bromure de sodium, provoquant une intoxication grave. Un cas rare qui illustre les dangers d’une utilisation non encadrée de l’IA pour des questions de santé.

- Par Stanislas Deve

- Commenting

- Mininyx Doodle / istock

Un simple conseil mal interprété sur ChatGPT peut conduire à une hospitalisation prolongée. C’est l’expérience malheureuse d’un Américain de 60 ans, racontée par trois médecins de l’université de Washington dans la revue scientifique Annals de la médecine interne, et relayée par The Guardian. A l’heure où l’on a tendance à croire l’intelligence artificielle (IA) sur parole, ils mettent en garde contre l’usage non encadré des chatbots pour des questions médicales.

Une substitution aux conséquences dramatiques

Le patient, ancien étudiant en nutrition, avait lu que le sel de table (chlorure de sodium) pouvait nuire à la santé. Après avoir consulté ChatGPT, il a cru pouvoir remplacer le chlorure par du bromure de sodium, un composé jadis utilisé comme sédatif au début du XXe siècle. Pendant trois mois, il a donc suivi ce régime improvisé.

Résultat : il a développé un bromisme, une intoxication au brome – une substance notamment utilisée pour désinfecter l’eau des piscines – aujourd’hui rare mais autrefois responsable de près d’un cas psychiatrique sur dix. Les symptômes incluent paranoïa, hallucinations, insomnie, soif intense, et éruptions cutanées.

Admis aux urgences pour délire paranoïaque – il était persuadé que son voisin tentait de l’empoisonner – l’homme a refusé l’eau du service, affirmant distiller lui-même son eau. Son état s’est rapidement dégradé, avec hallucinations auditives et visuelles, au point de tenter de s’évader. "Son taux de bromure était de 1.700 mg/L, contre 0,9 à 7,3 mg/L normalement", précisent les auteurs de l’article. Le traitement a consisté en une diurèse saline intensive pour éliminer le toxique.

L’IA en question

Les médecins n’ont pas pu vérifier les échanges réels entre le patient et ChatGPT, mais en testant eux-mêmes le chatbot (dans des versions antérieures à GPT-5), ils ont constaté que le bromure était effectivement cité comme substitut potentiel du chlorure, sans avertissement clair ni questionnement sur le contexte – "comme l’aurait fait un professionnel de santé".

Les auteurs alertent : l’IA peut "générer des inexactitudes scientifiques, manquer de recul critique et alimenter la désinformation". Si les nouvelles versions, comme GPT-5, intègrent davantage de garde-fous et rappellent ne pas remplacer un avis médical, le risque demeure pour un utilisateur non averti.

Ce cas souligne ainsi l’importance de vérifier toute information de santé auprès d’un professionnel qualifié. Dans un monde saturé de données, savoir poser les bonnes questions est aussi crucial que les réponses obtenues.